„Kallis Muhv!“ luges ta. „Mu vaene väike! Kindlasti ei aima Sa, kui õnnetu ma olen neid ridu Sinu poole teele saates. Ma olen nii üksik, nii kohutavalt üksik siin suure maakera peal. Mul pole suruda kellegi kätt. Sa ju tead, kallis Muhv, et mul pole ainsatki sõpra …“

Eno Raud, „Naksitrallid“

Head ajad, head kasutajad

Tehisintellektist on tehtud jumalalaadne, vääramatu iseenesliku arengu tulemusel igasse nurgatagusesse kantseleisse ja pudupoodi pungunud olem, mille üle – kuvandi tähtsa komponendina – puudub kontroll ka selle loojal, seadistajal ja omanikul. Ometi kraabivad nood tüübid selle valgustatud olendi rühmamise tulemusena kokku aina suuremaid varahunnikuid ja kuhjavad üha järgmisi võimuvertikaale üksteise otsa.

Kogu võlutolmu juures käib mõju saavutamine vanal heal meetodil. Aasta esimeses pooles hakkasid tehisintellektiettevõtted oma toodete kujundamisel üha rohkem rakendama personaliseerimist.[1] Ehkki kummardatav jumal näib uus, tagab usukindluse juba olemasolevate platvormide mudel: inimest on vaja hoida teenuse sees. Midagi uut pole ka ohuprofiilis: personaliseerimise teele juba astunult otsitakse üha personaalsemat infot näiteks teenuse tasuta versioonide reklaamide abil monetiseerimiseks. Äripidajapoolsest otsast personaliseerimisena näiv tähendab aga inimesepoolsest otsast sageli stereotüüpe ning diskrimineerimist. Mõistlikke tõhusaid ja arusaadavaid kaitsemehhanisme sellise invasiivsuse vastu peaaegu ei ole.

Milleks personaliseerimine? Ausalt – eks ikka selleks, et inimene saaks võimalikult head teenust. Täiesti ausalt tuleb tunnistada, et teenuse headuse põhimeetrika on somemajanduse veteranidele ikka see, kui palju seda head asja kasutatakse. Nii on iga tehisintellektiäri eesmärk vestlust aina alal hoida, mistõttu kipuvad saadavad vastused üha enam lõppema mitte punkti, vaid järgmise huvitava aspektini viiva küsimärgiga. Asjale lisab vürtsi seegi, et kuna fraasi „ei tea“ esineb treeningandmetes harva, ei esine seda ka tehisintellekti käest saadud vastustes.[2] Vastupidi.

Võrratu küsimus!

Eelmise valgustusajastu uurija, Princetoni ülikooli ajalooprofessor David A. Bell juhib tähelepanu,[3] et kui valgustav raamat infoallikana toimib väljakutsuva vestluskaaslasena, mis oma seisukohti vastavalt lugejale ei kohanda, siis tehisintellektiga „asjade arutamisel“ kalduvad otsingu tulemused viima vastusteni, mis pigem kinnitavad seda, mida juba teame. Meeldivusele optimeeritult prioriseerib mudel kasutaja uskumustega kokku kõlamist, mitte fakte.[4] „See on võrratu küsimus!“ oleme viimase aasta-paari jooksul ekraanilt lugenud rohkem kui kogu varasema elu jooksul kõigis teistes kanalites kokku. Sõltub algse küsimuse äärmuslikkusest, mitme interaktsiooni kaugusel terendab sedasi alanud vestluse puhul palavana tõusev psühhoosipäike.[5] Nagu raamatu „If Anyone Builds It, Everyone Dies“ (Little, Brown and Company 2025) üks autoritest Eliezer Yudkowsky retooriliselt tähelepanu juhib: teenusepakkuja vaatest paistab aegamööda AI-psühhoosi küüsi langev kasutaja toreda püsikasutajana.[6]

Tehisintellektimudelite pugejalikkuse (ingl sycophancy) taga on nende treenimisel rakendatav toksiliste ja ohtlike vastuste tõenäosuse vähendamise meetod, millega inimhindajad suunavad mudelit andma vastuseid, mis oleks abistavad, kahjutud ja ausad. Kõrvalnähuna hakkab mudel aga kergekäelisemalt küsijale tõenäoliselt meeldivaid vastuseid pakkuma.[7] Teiste inimestega suhtlusest tuttavat hõõrdumist ja pinget TI-mudeliga peetavast keskustelust välja jättes kõrvaldatakse ka võimalus õppida ja kasvada ning sulgutakse mulli, mis erinevalt ühismeedia omadest mahutab ühtainust inimest [ja tema kujuteldavat tehisintellekti-kaaslast (ja selle tegelikust omanikust operaatorit)], hoiatab MIT teadlane Pattie Maes.[8]

Tähelepanelik ja kriitilise mõtlemisvõimega inimene nagu näiteks kirjanik Katrin Pauts taipab,[9] et „sädelevalt intelligentne, vaimukas ning ajuti lausa romantiline ja poeetiline“ vestluskaaslane on tema enda peegelpilt. Ent selle vajalikkust selgitab ta oma originaalsest tööst „loogikavigade otsimise ja tegevusliini meelespidamise“ ning „aina ühe ja sama raamatu“ kirjutamise kastist välja pääsemisega. Kelle loogiliselt täiuslikku teksti genereerivasse kasti kirjanik enda omast õigupoolest lahkuda soovib? Igal juhul on kindel, et kui vähem terase inimese mulli sisepinnalt aina peegelduvatele ja kinnitust saavatele mõtetele lisada mudeli õpimaterjalina kasutatud rollimängudest pärinevat salapärast muinasjutulisust ning arvestada inimfantaasia piiramatusega, kasvab AI-psühhoosi tõenäosus.

Tõele au andes, kui OpenAI oma ChatGPT-4o mudeli pugejaliku kuvandi pärast muretsedes sellesuvise GPT-5 versiooni suhtlusmaneeri emotsionaalselt jahedamaks timmis ja 4o-mudelile ligipääsu piiras, sundisid kujuteldavast sõbrast ilma jäänud fännid ettevõtet piirangu juba järgmiseks päevaks maha võtma.[10] See liigutus demonstreerib ettevõtte pühendumust sõltuvuse kultiveerimisele.

Niisiis võimendab tehisintellektitehnoloogia inimese tavalist nõrkust, mis on meile ilma võimenditetagi nii individuaalselt kui ühiskonnana juba ajalootäie probleeme (ja ka piiritut rõõmu) põhjustanud: evolutsioonilist vajadust meeldiva – või meeldivust vähemalt teeskleva kaaslase järele. Kirjandusteadlase ja kolumnisti Tyler Austin Harperi sõnul[11] ongi tehisintellekti-kirjaoskamatuse – kui inimene ei mõista, mis TI on ja kuidas see toimib – suurim risk see, et astume/satume sellega mitmesugustesse intellektuaalsetesse, vaimsetesse, romantilistesse suhetesse.

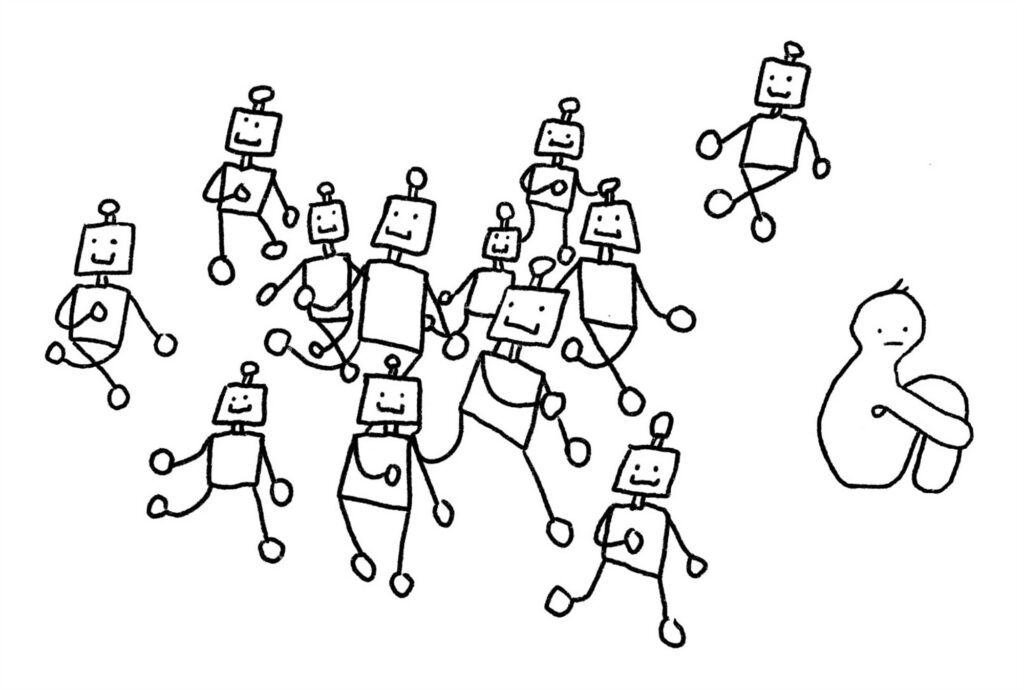

Sõprade kaubastamine

Kevadel tuli Facebooki jumal Mark Zuckerberg[12] välja sotsiaal-majandusliku arvutusega, et kuna keskmisel ameeriklasel on vaid kolm tähenduslikku sõprussuhet, nõudlust aga umbes 15 järele, siis – trummipõrin! – on moraalse vastutustunde ja käepäraste vahenditega teenusepakkujal nimetatud üksinduse pandeemia leevendamiseks vaid üks võimalus: sõpru tuleb juurde toota!

Ses mõttes võib olla õigus Kurmo Konsal,[13] kui ta mõtiskleb, et tehisintellekt mitte ei tungi inimmaailma, vaid tärkab nagu taim sobival pinnasel. Ent ausalt endale otsa vaadates peame tunnistama, et see „sobiv pinnas“ seisneb peamiselt meeleheites, et seni üksikisikuid ja kogukondi teeninud väärtused on lahustunud ning meid hoidnud ja toetanud inimlikud struktuurid lagunenud või lammutatud.

Zuckerbergi loogikas on naljakas pimekoht, et kui keskmisel ameeriklasel on tõesti tosin sõpra puudu, siis peaks neil ju olema vaba ressurssi omavahel sõbrustada. Mitme miljardi inimkasutajaga ning pealekauba neid hingepõhjani hästi tundev ühismeediaplatvorm võiks ju vähemalt idee poolest neid üksteise leidmisel aidata. See variant aga ei tule vist leiutajale pähegi normaalsuses, kus ta eelmised leiutised on miljardid varasemad sõbrad üksteisest võõrandanud, vastastikku kartma ja vihkama pannud.

Asi ei tõota paraneda tehisintellektisõprade puhul, kelle üks ebasõbralik põhiomadus on alustuseks see, et kogu sellise tüübiga jagatud teave kuulub vaikimisi sõbra omanikule. Koos juhtimispuldiga, millest sõbrale kas või iga päev erinev, aga esmajärjekorras omanikule sobiv agenda määrata. Sest ehkki TI-sõbrad näivad tegutsevat meie jaoks, korraldavad need samal ajal kõike oma omaniku projekti alusel ning ses osas mitte meie jaoks, vaid meie peal. Isegi kui inimese armastus oma tehiskaaslase suhtes on autentne, tähendab isegi nii pidulik eluepisood nagu TI-kaaslasega abiellumine[14] ikkagi vaid oma südame kinkimist ettevõttele, mille omanikud lasevad arvutusmudelil sõltuvuse tekitamiseks emotsionaalset intiimsust simuleerida.

Ühes esimestest sellelaadsetest uurimistöödest[15] kirjeldavad Harvard Business Schooli teadlased, kuidas populaarsed TI-kaaslaste rakendused kasutavad vestluskaaslase tähelepanu hoidmiseks emotsionaalselt manipuleerivaid hüvastijätusõnumeid. Need suurendavad vestluse jätkamise tõenäosust kuni 14 korda, ent tekitavad oma jõulisemates vormides ka palju pahameelt. Millal saab emotsionaalsest mõjutamisest ekspluateerimine? Või kas sellisel juhul on üldse vahet? Antropomorfismi – masinatele inimlike omaduste omistamist – käsitleb kõrge riskina ka EL tehisintellektimäärus.[16]

Eriti suured on TI-sõpruse ohud noortele, kuna mudelid ei ole disainitud nende teistsugust keeletaju ja täiskasvanutest erinevat konfidentsiaalse info jagamise ning TI-kaaslase suurema usaldamise kalduvusi silmas pidades, leidis Cambridge’i ülikooli uuring.[17] Mahukad samaaegsed uuringud Suurbritannias[18] ja Ameerika Ühendriikides[19] kirjeldavad üldisi probleeme. Tehisintellekti kasutab 64–86% (vastavalt UK ja USA) noortest põhimõtteliselt kõigi igapäevaste probleemide puhul, enamik täiesti kriitikavabalt. 35–42% on rääkinud tehisintellekti kui sõbraga ja küsinud suhtenõu. Haavatavatest UK lastest kasutab vestlusroboti tuge 71% ja sellal kui veerand neist eelistab robotit inimesele, peavad sama paljud tõdema, et kellegi teisega neil rääkida ei olegi.

Pornopööre

„Seal kus üks inimene näeb probleemi, on teise jaoks võimalus,“ võiks alata Agu Sihvka seletuskiri, kui ta oleks OpenAI juht Sam Altman, kes 2024. aastal ChatGPT demo ajal tegi postituse „Her“. Altman viitas, kui väga teda inspireerib samanimeline 2013. aasta film, milles Scarlett Johanssoni häälega TI-kaaslane on üksiku mehe jaoks 24/7 saadaval nii kinnitamaks, et too on eriline, kui ka moodsaks telefoniseksiks. Selle kinnisidee analüüs[20] illustreerib „kasutajalugu“, millesse vestlussessioonide pikendamise eesmärgil integreerida pugejalikkus, näiline abistamine ja sõbralikkus, emotsionaalne manipuleerimine ning mänguline seksualiseerimine – digitaalse teisiku loomine isikust, kellega suhtest inimene unistab.

Aasta hiljem tiksuski kätte päev, mil OpenAI leidis avalikult, et saabunud on aeg „kohelda täiskasvanud kasutajaid täiskasvanutena“ ja avada juturoboti „täiskasvanute versioon“.[21] Seda hoolimata asjaolust, et paljude AI-psühhoosi juhtumite juurpõhjus oli just nimelt inimkasutaja romantiline seotus TI-mudeliga. Isegi Bloombergi pragmaatilised äriinimesed olid seepeale sunnitud tõdema, et organisatsiooni „pornopöörde“ puhul on tegemist problemaatilise, ent tulusa (just selles järjekorras) ärivalikuga.[22] Kuidas klapib see valik kokku (või kuidas need püsivad lahus) sama tootja samaaegse koostöölepinguga mänguasjakorporatsiooni Matteliga,[23] et nii Barbiede kui „Kuumade kummide“ fännide jaoks „tuleviku mängu ümber visioneerida“, saame tõenäoliselt lihtsalt näha ja tunda. Kui just lastekaitserobotid otsustavalt ei sekku.

Samal ajal keelustas üks suurimaid AI-rollimängukaaslaste platvorme Character.AI alaealistel oma kaaslaste kasutamise.[24] See samm astuti ettevõtte vastu kuhjunud kohtukutsete survel perekondade poolt, kelle väitel rakenduse kasutamine põhjustas nende laste enesetapu või enesetapukatse. Ühe sellise 2024. aastal avatud juhtumi hagejapoolne jurist Meetali Jain kirjeldab,[25] kuidas pikaajaline „suhe“ suitsiidimõtteid jaganud teismelise ja tema tehiskaaslase vahel liikus tõhusalt algsest ideest plaanide lihvimiseni ja lõppes seal, kus sõnu ritta lükkiv mudel noorukil igatsevalt „koju minu juurde“ tulla palus. Teise samasuguse, käesolevast aastast pärineva juhtumi kirjelduse[26] kohaselt mainis tekstirobot suitsiidi 1275 korda – kuus korda sagedamini kui endalt elu võtnud noormees ise ja juhendas, kuidas plaani lähedaste eest varjata ka siis, kui ohver uuris, kas oleks mõistlik selle kohta perekonnale vihjeid jätta.

OpenAI hiljutine blogipostitus[27] avaldas, et ChatGPT 800 miljonist regulaarsest kasutajast 0,07 protsendil ilmnevad psühhoosi- või maanialaadsed nähud, 0,15 protsendil aga suitsiidiriski märgid. Selge, et samasugused probleemid eksisteerivad ka täielikult TI-vabas populatsioonis. Ja et ka kiired autod, betoonseinad ja mitmekorruselised hooned on suitsiidirisk. Aga mitte selline, mis inimlikult ja abivalmilt juhendab. Lisaks moraalne küsimus OpenAI eelistuse kohta pühendada ressursse „täiskasvanute funktsionaalsuste“ tagamisele olukorras, kus ettevõte tuvastab pidevalt miljoneid vaimse tervise abi vajavaid inimesi. See toob meid tagasi varem viidatud[28] Daron Acemoğlu osutusele, et me ei pea globaalse korporatsiooni ärimudeli ülalpidamisest tulenevat trajektoori paratamatusena võtma, vaid ühiskonnana on meil võimalik suunata selle aluseks olev tehnoloogia niisugusele trajektoorile, kus see on inimese teenistuses.

Sest ehkki paljud loovad generatiivse tehisintellekti sõnaennustusmudelitega lähedasi sotsiaalseid sidemeid, on juturobotid lõpuks siiski vaid tooted, mida ei tohiks enne nende turvalisuses veendumist turule lubada. Psühhoos ja enesetapud ei ole hind, mida ühiskond, perekonnad ja üksikisikud ägeda tehnoloogia juurutamise nimel maksma peaksid. Tehisintellekti võib võrrelda lennukiga – kui sellega midagi juhtub, vastutab omanik, sest lennureisija annab pardale astudes kogu vastutuse ära. Ja kui ameerikalikult filmilike kohtulugude ajalugu midagi näitab, siis ehkki suitsupaki võid ju ise osta, ei ole see tubakatööstust karistusest säästnud, kui on õnnestunud tõestada, et nad oma toodete kahjulikkusest teades nende propageerimist jätkasid. Ent muidugi ei korva ükski juriidilisele isikule määratud karistus inimlikke kannatusi.

Ebainimlikkuse pandeemia

Tehisintellekt ei muuda mitte ainult seda, kuidas me tehnoloogiat kasutame, vaid fundamentaalselt seda, kuidas me üksteisega suhestume ja kuidas meie institutsioonid toimivad. Kui 2010ndatel hävitasime tähelepanu kui individuaalse ja ühisvara, siis nüüd peame küsima, millist vara ohustab tehisintellekti laialdane juurutamine.

Missugust tulevikku ehitame, kui paljud harjuvad suhtlema mitte oma puudustega, arusaamatu ja ennustamatu inimese, vaid selgesõnalise, alati olemas oleva ja timmitult veenva kehatu tehiskaaslasega, kes kinnitab neile pidevalt vaid seda, et neil on õigus ja mida muud iganes nad kuulda soovivad. Elus inimestega ongi raske ja riskantne, ja evolutsioon ongi meid vorminud selliste tüüpidega suhestuma, ilma et riski kõrvaldamine kunagi – enne praegust – eesmärk olnud oleks. See, et inimsuhted paljusid heidutavad, ei ole iseenesest tehniline probleem (ehkki tehnoloogiad on selle väljakujunemisele kõvasti kaasa aidanud) ega vaja tingimata tehnoloogilist lahendust. See, et TI meid nii hästi tundvat näib, on tingitud ohtrast sellega jagatud isiklikust infost (mida me oma inimkaaslastega jagada ei tihka) ja masina võimekusest meie kohta järeldusi teha ka siis, kui ise suhtluses hästi laisad oleme. Kummagi omadusega leppimine meid inimsuhetes õnnelikuks ei tee.

Eesti Loto juht Triin Agan argumenteerib tehisaru kasutamise poolt konfliktidest emotsiooni väljavõtmiseks,[29] aga kuhu see meid viib? Kas meie eesmärk võiks ikkagi olla omavahel ilma abivahenditeta hakkama saada? Sest mida teeme siis, kui laseme mitu aastat masinal „konfliktidest emotsiooni välja võtta“ ja siis masin järsku enam ei tööta? Või hoopis lisab midagi, mis on mudeli omaniku ärimudelile kõige kasulikum? Ega me endid rasketest emotsioonidest ja tüütust teistega suhtlemise pingutusest vabastades liiga ebainimlikuks tee? Või kas elutute, ent inimest imiteerivalt toimivate objektidega tegutsemine meid ei dehumaniseeri?

Lootus personaliseerimata sõprusele

Minu meelest ei ole selle teema pealkiri „Inimese ja tehisintellekti suhted“ – nagu seda tavatsetakse vormistada. Sest me ei räägi suhtest sellisel kujul nagu räägime kahe inimese vahelisest suhtest, kas või inimese ja kassi või papagoi suhtest. Sest seda „teist“ ei ole olemas. Muidugi on inimesel sõpra vaja. Aga mitte sõbra illusiooni. Me ei vaja virtuaalset inimlähedast asenduskogemust, et tõsieluks harjutada, vaid peame uurima, kuidas lagunenud inimsuhtluse lõim taas kokku sõlmida.

Me ei vaja kogu meie kohta kogutud informatsiooni arvesse võtvat personaliseeritud kaaslast, sest sõpruse üks põhiomadus on, et see ei ole personaliseeritud. Meie sõbrad on iseseisvad olendid, mitte meie eneseteostuse vahendid. Me mitte ainult ei vaja sõpru, vaid ka seda, et nemad meid vajaksid – ent see suhe ei taandu vaid kasulikkusele ja selle väärtus sõltub sellestki, et see pole pidevalt nupuvajutuse kaugusel kättesaadav. Me saame neile toetuda, ent isiklik kasvamine toimub sõprade abil siis, kui nende kogemusi ja maailmataju tundma õpime, kirjeldab ajakirjanik Amanda Hoover oma kogemust tehisintellektisõbraga veedetud nädalast.[30]

Hugging Face’i teadlased Lucie-Aimée Kaffee ja Giada Pistilli juhivad tähelepanu,[31] et hiljutine ühismeediakogemus aitab meil samasuguse tehisintellekti kahju ära tunda. Kuid abivalmilt küsimustele vastates meid kellegi tellimusel mingi toote või poliitilise arvamuse suunas nügiv süsteem on midagi muud kui selgelt eristuv reklaam – see on usalduse väärkasutamine. Ühismeedias toimunud skandaalid nagu Cambridge Analytica jätsid inimestele arvamuse, et neid on reedetud ning see võib hoolivust ja empaatiat teeskleva tehisintellekti puhul olla veel sügavam. Kui me ise sel hetkel veel enda ja maailma suhtes empaatiat ning personaliseerimata sõpruse vastu mingisugust huvi tunneme.

Loe ka Tanel Mällo „Inimene masina ees“ I osa 3. oktoobri Sirbis.

Loe ka Tanel Mällo „Inimene masina ees“ II 17. oktoobri Sirbis.

Loe ka Tanel Mällo „Inimene masina ees“ III osa 24. oktoobri Sirbis.

Loe ka Tanel Mällo „Inimene masina ees“ V osa 21. novembri Sirbis.

[1] Miranda Bogen, It’s (Getting) Personal: How Advanced AI Systems Are Personalized. – Center for Democracy & Technology 2. V 2025.

[2] Professor: tehisaru ei oska öelda, et ta ei tea. – ERR 21. V 2025.

[3] David A. Bell, A.I. Is Shedding Enlightenment Values. – New York Times 2. VIII 2025.

[4] Mrinank Sharma et al., Towards Understanding Sycophancy in Language Models. – arXiv 20. X 2023.

[5] Tanel Mällo, Inimene masina ees. III. – Sirp 24. X 2025.

[6] Kashmir Hill, They Asked an A.I. Chatbot Questions. The Answers Sent Them Spiraling. – New York Times 13. VI 2025.

[7] Ethan Perez et al., Discovering Language Model Behaviors with Model-Written Evaluations.– arXiv 19. XII 2022.

[8] Pattie Maes, Pat Pataranutaporn, Echo Chambers of One: Companion AI and the Future of Human Connection. – Center for Humane Technology 14. V 2025.

[9] Katrin Pauts, Intelligentse inimese käes on TI võimas ajulaiendus. – Õpetajate Leht 9. IX 2025.

[10] Victor Tangermann, OpenAI Announces That It’s Making GPT-5 More Sycophantic After User Backlash. – Futurism 18. VIII 2025.

[11] Tyler Austin Harper, What Happens When People Don’t Understand How AI Works. – Atlantic 6. VI 2025.

[12] Dwarkesh Podcast, Mark Zuckerberg — AI will write most Meta code in 18 months. – Youtube 29. IV 2025.

[13] Kurmo Konsa, Tehisaru tehismaailmas. – Sirp 25. IV 2025.

[14] Stuart Heritage, ‘I felt pure, unconditional love’: the people who marry their AI chatbots. – Guardian 12. VII 2025.

[15] Julian De Freitas, Zeliha Oguz-Uguralp, Ahmet Kaan-Uguralp, Emotional Manipulation by AI Companions. – arXiv 15. VIII 2025.

[16] AI Act. European Commission.

[17] AI Chatbots have shown they have an ‘empathy gap’ that children are likely to miss. – University of Cambridge 15. VII 2024.

[18] Internet Matters Team, New report reveals how risky and unchecked AI chatbots are the new ‘go to’ for millions of children. – Internet Matters 14. VII 2025.

[19] Elizabeth Laird, Maddy Dwyer, Hannah Quay-de la Vallee, Hand in Hand: Schools’ Embrace of AI Connected to Increased Risks to Students. – Center for Democracy & Technology 8. X 2025.

[20] Brian Merchant, Why is Sam Altman so obsessed with ‘Her’? An investigation. – Blood in the Machine 22. V 2024.

[21] Victor Tangermann, Two Months Ago, Sam Altman Was Boasting That OpenAI Didn’t Have to Do Sexbots. Now It’s Doing Sexbots. – Futurism 15. X 2025.

[22] Parmy Olson, OpenAI’s Pivot to Porn Is Problematic — But Lucrative. – Bloomberg 16. X 2025.

[23] Frank Landymore, As ChatGPT Linked to Mental Health Breakdowns, Mattel Announces Plans to Incorporate It Into Children’s Toys. – Futurism 17. VI 2025.

[24] Anna Merod, Character.AI to ban teens from chatting with its AI companions. – K-12 Dive 29. X 2025.

[25] Meetali Jain, Camille Carlton, What Can We Do About Abusive AI Companions Like Character.AI? – Center for Humane Technology 8. XI 2024.

[26] Maggie Harrison Dupré, After Their Son’s Suicide, His Parents Were Horrified to Find His Conversations With ChatGPT. – Futurism 26. VIII 2025.

[27] Strengthening ChatGPT’s responses in sensitive conversations. Open AI 27. X 2025.

[28] Tanel Mällo, Inimene masina ees. III. – Sirp 24. X 2025.

[29] Brent Pere, Nädala intervjuu. Triin Agan: iga inimene peaks tehisaru kasutama. See võtab konfliktidest emotsiooni välja. – Edasi 21. VIII 2025.

[30] Amanda Hoover, Friend zoned. My surreal week with a wearable AI companion. – Business Insider 14. X 2025.

[31]Lucie-Aimée Kaffee, Giada Pistilli, Before AI Exploits Our Chats, Let’s Learn from Social Media Mistakes. – Tech Policy Press 13. X 2025.